Nous sommes fiers d’annoncer la sortie d’Interpreto, une nouvelle bibliothèque open-source dédiée à l’explicabilité des modèles de traitement du langage naturel (NLP) conçue et pilotée par ANITI et l’IRT Saint Exupéry, dans le cadre de deux grands programmes de recherche DEEL et FOR.

Le développement a été porté par Fanny Jourdan (chercheuse à l’IRT Saint Exupéry) et Antonin Poché (doctorant à l’IRIT et l’IRT Saint Exupéry), avec la collaboration d’une équipe interdisciplinaire réunissant partenaires académiques et industriels : Ampere, Renault Group, Thales, ScientaLab, CentraleSupélec, IRIT, Khoury College of Computer Sciences.

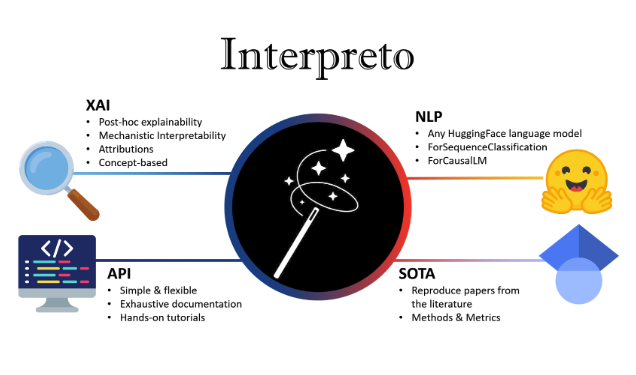

Cette toolbox réuni pour la première fois les meilleures méthodes de la littérature qui permettent de comprendre pourquoi un modèle Transformer prend une décision et les rend faciles d’utilisation : une étape cruciale pour garantir la confiance, l’équité et la robustesse des systèmes d’IA.

Un besoin croissant de transparence

Alors que les modèles de langage sont de plus en plus déployés dans des secteurs sensibles, l’explicabilité n’est plus une option mais une exigence. Contrairement aux bibliothèques existantes souvent limitées à une seule tâche, Interpreto propose une approche modulaire et unifiée, compatible avec l’écosystème Hugging Face.

Deux approches complémentaires : attribution et concepts

Interpreto se distingue en intégrant deux grandes familles de méthodes d’explication :

- Les méthodes d’attribution (Token-level) : elles identifient quels mots ou segments de texte ont le plus influencé une prédiction. Que ce soit par des méthodes de perturbation (LIME, SHAP, Sobol) ou de gradient (Integrated Gradients), Interpreto permet de visualiser précisément les indices textuels utilisés par le modèle.

- L’approche par concepts (Mechanistic Interpretability) : plus profonde, cette approche analyse les mécanismes internes du modèle. Elle permet d’extraire des concepts sémantiques (ex: “genre”, “lieu”, “sentimental”) au sein des couches cachées du Transformer grâce à des techniques d’apprentissage de dictionnaire (Auto-encodeurs creux, NMF, etc.).

Évaluer pour mieux faire confiance

L’une des forces de cet outil réside dans ses modules d’évaluation. Au-delà de la simple visualisation, Interpreto fournit des métriques quantitatives (Fidélité, Délétion, Insertion) pour mesurer la pertinence réelle des explications fournies, évitant ainsi les interprétations erronées.

Un outil pour la communauté

Développé dans une optique de recherche et de mise en pratique industrielle, Interpreto est disponible en open-source. ANITI invite les chercheurs et développeurs à s’emparer de cet outil pour rendre l’IA plus transparente.

- GitHub : https://github.com/FOR-sight-ai/interpreto

- Documentation : https://for-sight-ai.github.io/interpreto/

- Papier de recherche : https://arxiv.org/abs/2512.09730